具体描述

为了满足高等职业技术教育“以实践教育为主,理论上够用、适度”的教学要求。我们在四川大学出版社的组织下编写了这本《统计学原理》教材。本教材按照“文字简明、注重应用、便于教学”的原则介绍了统计的基本理论和基本方法。其内容主要包括:总论、统计调查、统计整理、总理指标和相归分析、统计预测与统计分析报告和国民经济核算体系共11章。除第十一计预测与统计分析报告和国民经济核算体系共11章。除第十一章外,其余各章均由正文和练习题两部分组成。

好的,这是一本关于深度学习与神经网络架构的图书简介。 --- 《深度学习:从理论基石到前沿架构》 本书导读:驾驭智能的脉络 在当今科技浪潮的中心,深度学习无疑是最具变革性的力量。它不仅仅是一种算法的集合,更是一种重塑我们与数据交互、理解复杂模式并构建智能系统的全新范式。本书《深度学习:从理论基石到前沿架构》旨在为读者提供一条从零开始、深入剖析这一前沿领域的系统化学习路径。我们摒弃了浅尝辄止的介绍,致力于构建一个扎实、严谨且极具实践指导性的知识体系。 本书的目标读者群广泛,涵盖了希望系统掌握深度学习理论的计算机科学专业学生、渴望将先进AI技术应用于实际业务场景的数据科学家、以及寻求技术视野拓展的软件工程师和研究人员。我们假设读者具备基础的微积分、线性代数和概率论知识,但即便如此,书中也会对必要的前置数学概念进行精炼的回顾,确保理解的无缝衔接。 第一部分:理论的基石——理解学习的本质 深度学习的成功并非偶然,它建立在一系列深刻的数学和统计学原理之上。本部分将为读者打下坚实的理论基础。 第一章:机器学习的复兴与神经网络的起源 我们将追溯人工神经网络(ANNs)的历史脉络,从感知机(Perceptron)的局限性,到反向传播算法(Backpropagation)的重大突破。本章详细解析了神经网络的结构单元——神经元模型,阐述了激活函数(如 Sigmoid, ReLU, Tanh)的选择如何影响模型的表达能力和训练稳定性。我们着重讨论了梯度下降(Gradient Descent)及其变体(SGD, Momentum, RMSProp, Adam)在优化非凸损失函数空间中的核心作用,以及学习率调度策略对收敛速度和精度的影响。 第二章:损失函数、正则化与模型评估 有效的模型训练离不开恰当的损失函数设计。本章深入比较了回归任务中的均方误差(MSE)、分类任务中的交叉熵(Cross-Entropy),并探讨了结构化预测中特有的损失函数。重点聚焦于模型泛化能力的保障:正则化技术。从经典的L1/L2权重衰减,到Dropout机制的随机性引入,再到批归一化(Batch Normalization)如何稳定内协方差偏移(Internal Covariate Shift),实现更快的收敛。同时,我们将详尽阐述过拟合与欠拟合的诊断方法,以及交叉验证在评估模型稳健性中的关键地位。 第三章:优化器的精妙设计 本章将优化算法提升到核心地位,因为它直接决定了模型能否从数据中有效提取信息。我们不仅会复现经典的一阶优化器,更会深入探究二阶近似方法(如牛顿法和拟牛顿法在有限样本环境下的局限)。核心篇幅将留给自适应学习率优化器,如 AdaGrad、RMSProp 和 Adam 系列。我们将从数学推导上剖析它们如何基于历史梯度信息动态调整每参数的学习步长,并讨论它们在处理稀疏数据和大规模模型时的优缺点权衡。 第二部分:核心架构——从序列到空间 理解了基础优化原理后,本部分将系统介绍现代深度学习的两大支柱架构:卷积网络(CNN)和循环网络(RNN)。 第四章:卷积神经网络(CNN)的视觉革命 CNN 是现代计算机视觉领域不可动摇的基础。本章从二维卷积操作的数学定义出发,清晰解释了感受野(Receptive Field)、权重共享和局部连接的优势。我们详细分析了经典网络结构,包括 LeNet-5、AlexNet、VGG 的堆叠式设计哲学。更重要的是,本章深入讲解了残差连接(Residual Connections)在 VGG 等深层网络中解决梯度消失问题的关键性创新,以及 Inception 模块在多尺度特征提取上的巧妙平衡。 第五章:序列建模的艺术——循环神经网络(RNN) 处理时间序列、自然语言等序列数据,RNN 展现了其独特的优势。本章构建了基本的 RNN 单元,并剖析了其在处理长距离依赖问题上的固有缺陷——梯度消失/爆炸。随后,我们将重点解析如何利用门控机制克服这些挑战:长短期记忆网络(LSTM)的输入、遗忘、输出门结构,以及门控循环单元(GRU)的简化优雅性。本章还讨论了序列到序列(Seq2Seq)模型的基本框架,为注意力机制的引入做铺垫。 第三部分:前沿架构与范式——迈向通用智能 在掌握了基础模块后,本部分将聚焦于当前驱动前沿应用的核心技术和新兴学习范式。 第六章:注意力机制与 Transformer 的崛起 注意力机制(Attention Mechanism)是近年来最关键的突破之一,它使得模型能够动态地聚焦于输入信息中最相关部分。本章将详细介绍自注意力(Self-Attention)的 Scaled Dot-Product 运算,并全面解析 Transformer 架构的编码器-解码器结构。我们将深入探究多头注意力(Multi-Head Attention)如何捕捉不同表示子空间的信息,以及位置编码(Positional Encoding)如何弥补 Transformer 缺乏序列顺序信息的缺陷。 第七章:生成模型与对抗学习 生成模型旨在学习数据的真实分布,从而生成新颖、逼真的样本。本章对比了变分自编码器(VAE)和生成对抗网络(GAN)。对于 GAN,我们将细致剖析生成器与判别器之间的博弈过程,讨论模式崩溃(Mode Collapse)等常见问题,并介绍如 WGAN、DCGAN 等改进型架构,用以提升训练的稳定性和生成质量。 第八章:模型的高效部署与可解释性 一个优秀的模型不仅需要在实验室中表现出色,更需要在实际环境中高效运行。本章探讨了模型压缩技术,包括权重剪枝(Pruning)、量化(Quantization)以及知识蒸馏(Knowledge Distillation),以减小模型体积并加速推理速度。此外,面对深度学习的“黑箱”特性,我们引入了解释性AI(XAI)的概念,介绍如 Grad-CAM 等可视化技术,帮助用户理解模型做出决策背后的依据,增强信任度和可调试性。 结语 《深度学习:从理论基石到前沿架构》不仅仅是一本教科书,它是一份详尽的技术路线图。我们通过严谨的数学推导、清晰的算法描述和丰富的实例分析,力求让读者不仅“会用”这些强大的工具,更能“理解”它们为何有效。掌握本书内容,即是掌握了通往下一代智能系统的关键钥匙。 ---

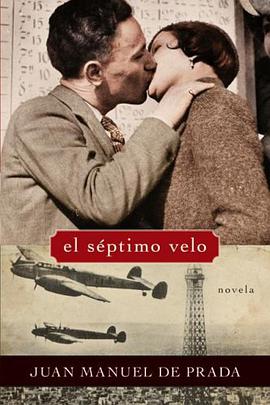

作者简介

目录信息

读后感

评分

评分

评分

评分

评分

用户评价

评分

评分

评分

评分

评分

相关图书

本站所有内容均为互联网搜索引擎提供的公开搜索信息,本站不存储任何数据与内容,任何内容与数据均与本站无关,如有需要请联系相关搜索引擎包括但不限于百度,google,bing,sogou 等

© 2026 qciss.net All Rights Reserved. 小哈图书下载中心 版权所有